„METROPOLIS” ponownie obejrzane… i nadchodzące1

W takim systemie, teoretycznie, lekarz ma możliwość osobistego kontaktu nawet z 450 pacjentami dziennie. Biorąc pod uwagę zatłoczony świat z ograniczoną liczbą lekarzy, byłoby to niewątpliwie „efektywne”. Jednocześnie należy zadać pytanie, czy w tak intymnej relacji zawodowej czynnik ludzki nie został drastycznie ograniczony przez wprowadzenie technologii, która po prostu gromadzi informacje?

W istocie, to właśnie zdolność technologii do gromadzenia informacji w ogromnych ilościach może, prawdopodobnie, poszerzyć wiedzę lekarza w zakresie diagnozowania problemów pacjenta, a następnie albo leczyć go bezpośrednio, albo skierować do specjalisty. W konsekwencji, gromadzenie ogromnych danych na temat konkretnej choroby lub urazu powoduje, że leczenie pacjenta wchodzi w bezpośredni kontakt z „Big Data”.

Niestety, jak zauważono w innym miejscu, problem „Big Data” zaciemnia zdolność pojedynczego badacza do zachowania koncentracji. Według jednych szacunków każdego roku powstaje około 16,3 zetabajtów informacji, czyli mniej więcej równowartość 16,3 mld gigabajtów. Szacuje się, że do 2025 r. liczba wzrośnie dziesięciokrotnie13. Zauważono jednocześnie, że „przeszliśmy z epoki, która była bogata w treść, ale uboga w dane, do epoki, która jest bogata w dane, ale uboga w treść… [, i] jest to rewolucja epistemologiczna tak fundamentalna jaką była rewolucja kopernikańska14”.

Niewykluczone, że niezamierzoną konsekwencją tego „wybuchu danych”, może być tendencja lekarza do postrzegania pacjenta nie jako jednostki, ale przez pryzmat bazy danych. W rezultacie, diagnoza może nie być dokładna, ale jeśli „komputer tak mówi to, to tak musi być”. Jeśli baza danych jest dziełem społeczności medycznej lub agencji rządowej, to może mieć tendencję do stawania się „złotym standardem” dla całego społeczeństwa.

Dla przykładu w Stanach Zjednoczonych Departament Obrony w 2018 r. utworzył Połączone Centrum Sztucznej Inteligencji (Joint Artificial Intelligence Center), zwane JAIC lub „Jake”. Jego celem jest gromadzenie i wykorzystywanie statystyk i technologii informatycznych w celu wykorzystania Sztucznej Inteligencji (Artificial Intelligence – AI) do rozwiązywania dużych i złożonych zestawów problemów, które obejmują wiele systemów bojowych. Nie da się ukryć, że stworzenie tej bazy danych przez wojsko ma potencjalne implikacje i wpływ na politykę. Nie wiadomo, czy zebrane w ten sposób dane byłyby dostępne dla całej społeczności medycznej w formie nieprzetworzonej. Jeśli nie, to czy stają się one wewnętrznym mechanizmem, właściwie „tajemnicą państwową” służącą do ustalania rządowych/wojskowych decyzji w zakresie polityki strategicznej? Jeśli tak, to czy staje się częścią „złotego standardu” dla lekarzy? Z pewnością gromadzenie i przetwarzanie takich informacji ma wiele pokojowych zastosowań, takich jak wykrywanie i leczenie raka oraz zapobieganie samobójstwom15.

Po zdefiniowaniu „złotego standardu Jake’a”, z technologicznego punktu widzenia, jest już bardzo krótki krok do tego, aby stał się on częścią algorytmu, który jest de facto diagnostą, zastępując lekarza prowadzącego. W tym scenariuszu mamy do czynienia z podniesieniem poziomu „Big Data”, poprzez technologię AI16. Podczas gdy jest to rzekomo w służbie ludzkości, technologiczna soczewka ma potencjał odwrócenia spojrzenia na dane przez lekarza, co przypomina patrzenie na gwiazdę przez niewłaściwy koniec teleskopu17.

W kwestii cyberestetyki, nie ma chyba wątpliwości, że „napędzana efektywnością” mieszanka statystyki, technologii i zarządzania gabinetem stworzyła bardzo wydajny mechanizm dostarczania opieki zdrowotnej przeciętnemu pacjentowi18. Tak jest przynajmniej w Stanach Zjednoczonych i być może jest to model dla innych krajów rozwiniętych. Trzeci Świat jednak z definicji pozostaje w tyle, choćby z powodu stosunkowo ograniczonego dostępu do łączności internetowej. W takiej sytuacji dysproporcja w jakości opieki medycznej, a więc i samego życia, ma potencjalnie ogromne konsekwencje geopolityczne.

Jednak, podobnie jak w XVII w. w czasach Kartezjusza, doświadczamy obecnie gwałtownego wzrostu stopnia, w jakim nasza wiedza, np. informacje otrzymywane przez Internet, jest zapośredniczona technologicznie. Skutkiem tego może być odnowienie przez telerobotykę, czyli zdalne sterowanie urządzeniami robotycznymi za pomocą technologii, poglądu, że nasza wiedza o świecie jest zasadniczo pośrednia19.

Ta faza współczesnej rewolucji jest jeszcze bardziej złożona przez ekspansję wykorzystania danych syntetycznych. Zastąpienie „prawdziwych” danych przez wykorzystanie danych „syntetycznych” stwarza sytuację, w której dokładność wniosków jest coraz bardziej wątpliwa. W końcu jakakolwiek ocena dokładności danych, które są generowane z danych „syntetycznych” nie może być dokonana bez szerokiego badania procesu, w którym zostały one stworzone.

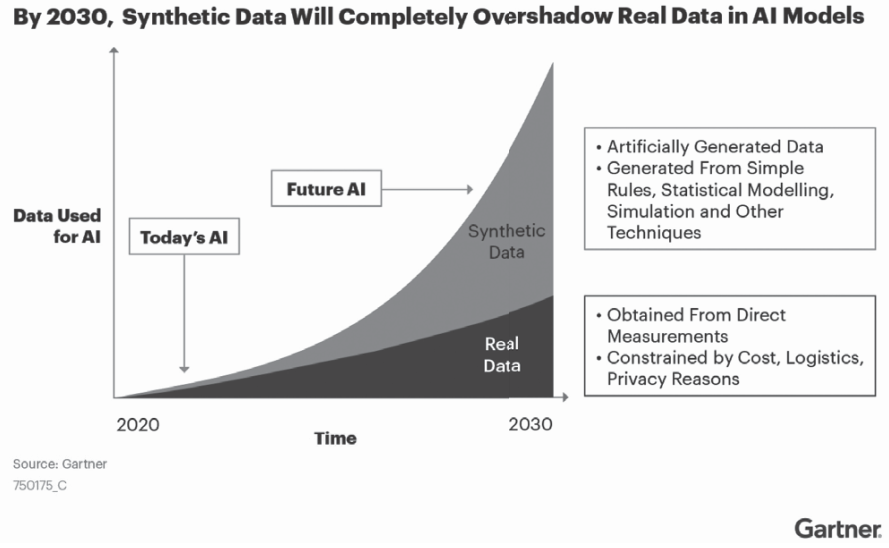

Przykładowo w raporcie z czerwca 2021 r. dotyczącym danych syntetycznych Gartner Research przewidział, że do 2030 r. większość danych wykorzystywanych w AI będzie sztucznie generowana przez reguły, modele statystyczne, symulacje lub inne techniki. Faktem jest, że prawdopodobnie nie będzie możliwe zbudowanie wysokiej jakości, wysokowartościowych modeli AI bez danych syntetycznych20.

Jak widać na rys. 1, implikacją tego raportu jest to, że w miarę jak objętość danych syntetycznych rozszerza się w coraz szybszym tempie, to „prawdziwe” nie. Podstawy modeli AI, wraz z ich wnioskami, mają tendencję do coraz większego odrywania się od ludzkiej „rzeczywistości”, której mają służyć. Jeśli nie da się jej zweryfikować, to produkt będzie mało przydatny, jeśli w ogóle.

W istocie, to faktycznie wtłacza cybernetykę ludzkiej interakcji do równania – „człowieczeństwo kontra efektywność”. Najprostszym przykładem tej interakcji jest język. Jest on zazwyczaj uznawany za oczywisty, jeśli zakłada się, że wszyscy mówią tym samym językiem, ale to niekoniecznie jest prawda. Ostatnie wydarzenia na styku technologii i zwiększonej dostępności danych doprowadziły do postępów w AI, które są więcej niż kontrowersyjne. Mogą one zmieniać paradygmat.